Остановитесь на мгновение и представьте себе мир, где видеть не всегда значит верить - где ваши зрительные и слуховые ощущения могут быть обмануты настолько совершенными технологиями, что поддельный видео- и аудиовизуальный контент кажется пугающе реальным. Добро пожаловать в реальность (и нереальность) глубоких подделок.

Введение в глубокие подделки

Определение фальшивок и их значение в современном цифровом мире

Термин "deepfake", представляющий собой смесь слов "deep learning" и "fake", многое говорит об этой области компьютерных наук. По сути, под deepfake понимаются манипулируемые видео или другие цифровые изображения, созданные с помощью сложных технологий искусственного интеллекта (ИИ). Используя алгоритмы машинного обучения под названием Generative Adversarial Networks (GANs), создатели порнографии deepfake создают реалистичные изображения или видео событий, которые никогда не происходили.

Стремительный взлет технологии deepfake вызвал бурные дискуссии об их растущем влиянии на распространение новостей, социальную дискуссию, развлечения и, возможно, даже политику. В современную цифровую эпоху, когда любой человек, имеющий подключение к Интернету, может мгновенно распространять информацию по всему миру, влияние таких высокоточных подделок уже невозможно игнорировать.

Известные примеры глубоких подделок, привлекших внимание

Отличительные примеры показывают, как фальшивки привлекли внимание аудитории в последние годы:

- Один из ярких примеров - манипулируемое видео, в котором генеральный директор Facebook Марк Цукерберг, казалось, заявлял о полном контроле над миллиардами украденных данных людей.

- Режиссер Джордан Пил использовал технологию deepfake для создания видео, в котором якобы показано, как тогдашний президент Барак Обама отпускает уничижительные комментарии в адрес президента Трампа.

- Глубокие подделки, основанные на знаменитостях, часто появляются в сети. Один из ярких примеров - актер Том Круз, играющий в гольф с невероятной реалистичностью в период блокировки COVID-19.

Эти примеры подчеркивают силу deepfakes в создании ложных нарративов с помощью синтетических медиа - и это лишь малая часть того, чего достигла эта относительно молодая технология на сегодняшний день. С постоянным развитием возможностей ИИ становится еще более важным понимать интригующие и в то же время опасные последствия этого развивающегося технологического феномена.

История глубоких подделок

Эволюция технологии глубоких подделок с момента ее появления до наших дней

Термин "Deepfake", объединяющий понятия "глубокое обучение" и "подделка", был впервые введен в 2017 году анонимным пользователем Reddit, который начал создавать и выкладывать в сеть поддельные видеоролики знаменитостей. Однако на самом деле основу понятия "глубокая подделка" можно отследить еще в конце 1990-х годов, когда ученые начали изучать концепцию цифровой замены лица.

Если перенестись в 2014 год, то новаторская исследовательская работа Google о FaceNet по сути стала основой для современных глубоких подделок. В FaceNet использовались сверточные нейронные сети (CNN) - разновидность алгоритмов машинного обучения - для изучения выражений лица и значительного расширения возможностей распознавания лиц.

В 2016 году технология совершила огромный скачок благодаря усовершенствованию генеративных состязательных сетей (GAN). Эти передовые алгоритмы позволили машинам генерировать изображения или видео из случайного шума, которые были значительно точнее, чем это было возможно ранее, что и стало основой современного процесса производства глубоких подделок.

В настоящее время глубокие подделки впечатляют своей реалистичностью благодаря значительному усовершенствованию моделей искусственного интеллекта и машинного обучения за прошедшие годы. Сегодня они стали настолько сложными, что для того, чтобы отличить подлинный контент от манипулируемых медиа, часто требуется экспертное человеческое мнение, дополненное специализированными инструментами для обнаружения фальшивок.

Популярные сценарии использования и достижения в области глубоких подделок с течением времени

От развлечений до политики, от артистизма до искажения личных данных - с момента своего появления фальшивки нашли огромное количество применений:

- Киноиндустрия: Знаковый дебют состоялся в 1977 году с голографическим посланием принцессы Леи из "Звездных войн", которое продемонстрировало базовую форму видеоманипуляций - предшественник сложных современных глубоких подделок.

- Веселье в социальных сетях: Фильтры Snapchat, манипулирующие лицами в режиме реального времени, позволили обычным пользователям познакомиться с технологией подмены лиц.

- Кампании политической дезинформации: Тем временем появились тревожные случаи, когда политические деятели якобы изображались совершающими действия или высказывания, не соответствующие действительности, - распространяющийся пожар, который вызвал немедленное беспокойство за наши демократические процессы.

- Художественное самовыражение: С другой стороны, художники и кинематографисты использовали технологии deepfake для создания инновационных сюжетов, вдохнув жизнь в исторические личности или добавив изюминку в рекламные кампании.

Эволюция технологии deepfake с момента ее появления и до сегодняшнего дня была не что иное, как революционной. Однако с учетом значительного совершенствования возможностей машинного обучения, стимулирующего ее развитие и расширяющего сферы применения, становится еще более важным установить строгий контроль и регулирование, чтобы не допустить превышения этических границ. Высокие технологии могут быть как созидательным инструментом, так и разрушительным; на протяжении всей истории существования deepfakes мы наблюдали, как это ярко проявляется в обоих направлениях.

Как создаются фальшивки?

Объяснение технологий, лежащих в основе создания фальшивок, включая машинное обучение и искусственный интеллект

Давайте разберемся, какие технологии лежат в основе глубоких подделок. По сути, они являются продуктом передовых технологий машинного обучения, в частности искусственного интеллекта под названием Deep Learning.

Deep Learning имитирует работу человеческого мозга, используя клетки или нейроны для постепенного распознавания закономерностей в данных. Оно состоит из алгоритмов, которые строят искусственные нейронные сети, наслаиваясь друг на друга, отсюда и "глубокое" обучение. При обсуждении вопроса о том, что такое deepfake, это является основой вашего ответа.

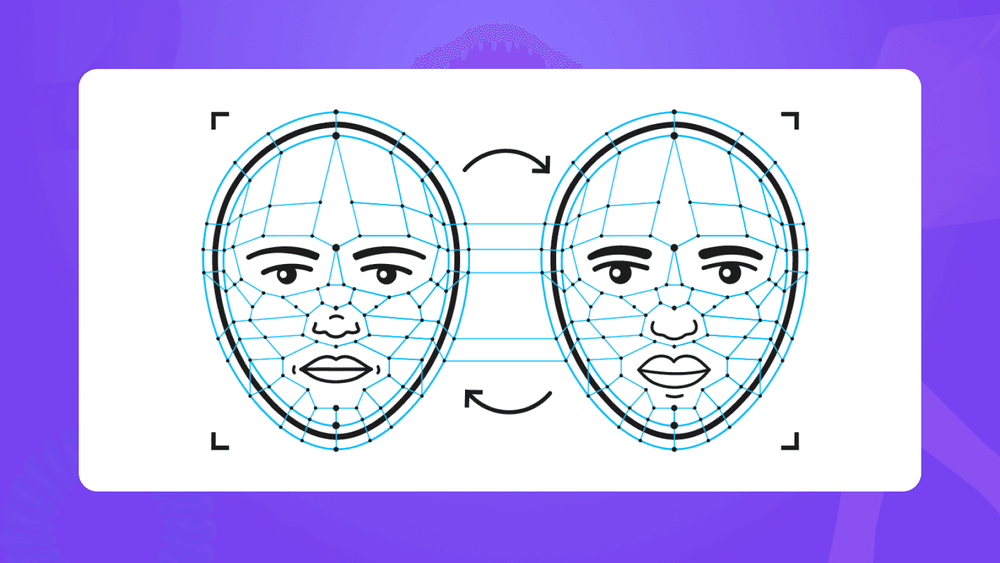

Чтобы создать глубоко подделанное видео или изображение, в дело вступают генеративные адверсарные сети (GAN). GAN воплощают в себе две системы искусственного интеллекта: одна создает ("Генератор"), а вторая оценивает ("Дискриминатор"). Генератор создает поддельные видео/изображения и пытается перехитрить дискриминатор, а дискриминатор тем временем учится отделять настоящие изображения от поддельного контента.

Вооружившись этими инструментами - Deep Learning и GANs, - вы можете приступать к созданию своих собственных фальшивок!

Подробный процесс создания поддельного видео или изображения

Создание высококачественного deepfake требует скрупулезности и времени, но ловкое управление искусственным интеллектом делает этот процесс менее обременительным. Вот краткий обзор:

- Сбор данных: Соберите множество изображений/видео, связанных с целевым лицом; скажем, актер А, чье лицо будет помещено на тело актера Б.

- Обучение: На этом этапе GAN получает тысячи ─ иногда даже миллионы ─ изображений/видео для обучения.

- Генерация лиц: После достаточного количества циклов обучения, называемых эпохами, появляется удивительная точность, когда генератор начинает генерировать изображения, зеркально отражающие обученные.

- Замена лиц: Далее запускается программное обеспечение, которое интеллектуально подставляет лицо актера A в кадры актера B, в результате чего получается готовое видео, которое выглядит так, как будто вместо актера B выступал актер A.

- Уточнения: Для усиления эффекта true-blue используйте методы постпродакшна, такие как цветокоррекция и смешивание.

Проблемы и ограничения, связанные с созданием реалистичных глубоких подделок

Несмотря на превосходную технологию deepfake, ее совершенствование сопряжено с целым рядом проблем:

- Зависимость от высококачественных данных: Впечатляющий набор требует большого количества фотографий/видео высокого разрешения с разных ракурсов при различном освещении. Любое некачественное изображение значительно снижает качество.

- Требования к вычислительным ресурсам: Тщательный процесс обучения требует мощных машин, оснащенных первоклассными графическими процессорами, способными обрабатывать большие объемы данных.

- Затраты времени: Не менее трудоемким является время, затрачиваемое на получение реалистичного результата; в зависимости от объема данных оно исчисляется днями и даже неделями.

- Требуются навыки: Создание убедительного deepfake также зависит от специальных навыков, охватывающих компьютерные науки, машинное обучение и ноу-хау в области видеомонтажа.

Несмотря на то что существующие инструменты уменьшили некоторые трудности, связанные с созданием глубоких подделок, достижение сверхправдоподобных результатов остается сложной задачей. Однако появление более надежных инструментов искусственного интеллекта постепенно упрощает этот процесс.

Воздействие и последствия глубоких подделок

В мире, где доминируют цифровые технологии, понимание многогранных сложностей, связанных с фальшивками, действительно имеет решающее значение. В целом, потенциальные последствия и влияние этой увлекательной и в то же время опасной технологии могут быть как негативными, так и позитивными.

Потенциальные негативные последствия фальсификаций

При рассмотрении вопроса "Что такое глубокая подделка?" необходимо учитывать возможность ее использования не по назначению. Глубокие подделки открывают определенные ящики Пандоры, которые могут привести к хаосу, если их не проконтролировать.

- Дезинформация - самая непосредственная опасность, связанная с широким распространением deepfakes, - это распространение дезинформации. Создавая очень реалистичный, но не соответствующий действительности визуальный контент, злоумышленники могут манипулировать общественным мнением, разжигать теории заговора или создавать мистификации, вызывающие необоснованную панику и катастрофы.

- Клевета - Высоко реалистичные пародии, созданные с помощью deepfakes, могут быть использованы для намеренного очернения чьей-либо личности. Такие клеветнические действия могут привести к непоправимому личному ущербу или профессиональной непригодности.

- Вторжение в частную жизнь - глубокие подделки представляют собой серьезную угрозу для частной жизни, поскольку для них требуются большие массивы данных - зачастую без получения соответствующих разрешений от тех, чьи данные используются.

Все эти факторы в совокупности создают мрачный фон, на котором мы должны рассматривать широкомасштабные последствия использования технологии deepfake.

Этические проблемы, связанные с глубокими подделками

Размышляя над вопросом "что такое deepfake", невозможно упустить из виду некоторые этические проблемы, связанные с их применением. Помимо вышеперечисленных, возникают глубокие моральные вопросы о правдивости, обмане и доверии в нашем цифровом обществе.

Глубокие подделки бросают вызов тому, как ведутся разговоры как на индивидуальном, так и на общественном уровне, нарушая нормы, которые мы до сих пор понимали в отношении подлинности и правдивости! По сути, их можно использовать как оружие, чтобы подорвать доверие общества к СМИ - неотъемлемому институту демократического общества!

Позитивное использование технологии Deepfake

Несмотря на повсеместный негатив, специалисты и энтузиасты утверждают, что при творческом и ответственном подходе глубокие подделки обладают потрясающим потенциалом в некоторых областях.

- Развлечения - киноиндустрия изучает потенциал deepfakes для снижения затрат и достижения беспрецедентных эффектов. Это позволяет кинематографистам использовать кадры или выступления актеров, которые скончались или недоступны для съемок.

- Искусство - Художники все чаще экспериментируют с искусственным интеллектом, чтобы расширить границы своих работ и сделать их более захватывающими. Создание визуальных образов, похожих на сны, с помощью алгоритмов машинного обучения открывает новые интригующие горизонты для цифровых художников.

По мере того как мы будем двигаться вперед, установление баланса между использованием положительных моментов и эффективным ограничением злоупотреблений будет играть ключевую роль в обеспечении благосостояния общества на фоне подобных технологических достижений. Я считаю, что борьба с "обоюдоострым мечом" под названием deepfake - это не только техническая, но и этическая задача, требующая коллективных усилий от технологов, законодателей, педагогов и нас, пользователей, в равной степени!

Обнаружение и борьба с глубокими подделками

Вникая в мир фальшивок, важно понимать, что эти сфабрикованные материалы могут представлять серьезную угрозу. К счастью, технологи по всему миру оперативно разрабатывают меры противодействия, чтобы решить эту проблему обнаружения фальшивок.

Методы и способы выявления фальшивого контента

В то время как изощренность технологии "глубоких подделок" продолжает расти, в последние годы появилось несколько методов, которые дают надежду отличить настоящий контент от поддельного. Позвольте мне пролить на них свет:

- Анализ микровыражений: Подлинные человеческие выражения демонстрируют мельчайшие движения лица, которые обычно трудно воспроизвести искусственно. Автоматизированный анализ микровыражений позволяет выявить эти тонкие несоответствия.

- Анализ моргания глаз: Люди моргают от 15 до 20 раз в минуту естественным образом. Часто алгоритмы, используемые для создания глубоких подделок, с трудом имитируют моргание, что делает этот показатель полезным для обнаружения.

- Криминалистический анализ: Он включает в себя тщательное попиксельное изучение видео или изображений на предмет аномалий или несоответствий, которые обычно оставляют после себя модели ИИ.

Однако важно помнить, что эти методы не являются полностью безопасными, учитывая экспоненциальный темп развития технологии глубоких подделок.

Технологический прогресс в обнаружении и предотвращении распространения фальшивок

Отвечая на вопрос "что такое deepfake", я могу с гордостью добавить, что по мере развития обманчивых подделок развивается и наша защита. Прогресс происходит постоянно, в основном благодаря технологиям машинного обучения и компьютерного зрения - тем самым инструментам, которые используются для создания глубоких подделок!

Подумайте об автоматизированных системах, использующих искусственный интеллект (ИИ) для быстрого сканирования контента на цифровых платформах и эффективного выявления потенциальных подделок на основе распознавания образов.

Более того, исследователи по всему миру экспериментируют с "состязательными сетями", когда одна нейронная сеть сначала создает синтетическое видео, а другая пытается выявить его ошибочность - таким образом, со временем улучшаются как генеративные способности, так и стратегии обнаружения.

Роль отдельных людей, платформ социальных сетей и правительств в борьбе с распространением вредных или злонамеренных подделок

Последняя линия обороны от вредоносного контента deepfake - это отдельные люди, платформы социальных сетей и правительства. Вот как они могут участвовать в борьбе с этой растущей цифровой угрозой:

- Частные лица: Получение знаний о том, что такое deepfake, и информирование о существующих методах обнаружения значительно помогает отличить реальность от подделок.

- Платформы социальных сетей: Борьба с глубокими подделками на начальном этапе - эти платформы могут использовать передовые инструменты обнаружения для тщательной проверки каждого размещенного контента на предмет аномалий.

- Правительства: Они играют важнейшую роль в разработке нормативных актов, контролирующих создание и распространение вредных подделок, а также в развитии здорового дискурса о правах на частную жизнь.

Если сочетать технологический прогресс с активным участием всего общества, можно смягчить значительную часть вреда, наносимого угрожающей технологией deepfake. Помните, что быть информированным - значит быть защищенным!

Юридические аспекты, связанные с глубокими подделками

Технология глубоких подделок, несомненно, имеет свои юридические проблемы. Законодательные органы по всему миру занимают различные позиции по этому вопросу.

В Соединенных Штатах Америки производство и распространение подделок не является ни прямо незаконным, ни полностью санкционированным. В нескольких штатах, включая Калифорнию и Техас, были приняты законы, направленные именно против подделок. Соответствующий закон в Калифорнии дает людям право подать в суд, если их голосом или изображением манипулировали обманным путем в течение 60 дней до выборов или если его использовали в порнографических материалах без их согласия.

В Китае, напротив, к этому вопросу подошли более широко, введя полный запрет на видеоролики deepfake, если они не имеют четкой маркировки как таковые. Кроме того, по китайским законам за создание злонамеренных клеветнических материалов deepfake можно получить тюремный срок.

Европейский союз (ЕС) также занимается этой проблемой, но в настоящее время не имеет специальных законов, касающихся феномена "что такое deepfake" в широком масштабе. Однако жертвы могут добиваться возмещения ущерба в соответствии с правом на стирание или "правом быть забытым".

Этические вопросы регулирования и цензуры в связи с технологией deepfake

В то время как соответствующие законы продолжают развиваться по всему миру, мы по-прежнему сталкиваемся с несколькими этическими дилеммами, изучающими параметры между свободой слова и защитой от вреда:

- Художественное самовыражение и обманчивая манипуляция: Некоторые считают, что создание подделок относится к художественному творчеству, которое может быть подавлено строгими правилами, но другие с этим не согласны, ссылаясь на возможность эксплуатации.

- Дилемма цензуры: Баланс между законодательством о вредном использовании и обеспечением свободы слова остается предметом постоянных дебатов.

- Проблемы конфиденциальности данных: Создание правдоподобных глубоких подделок требует доступа к большому количеству данных о человеке, что ставит под вопрос конфиденциальность.

Подводя итог, можно сказать, что понимание того, что такое deepfake, крайне важно, но также важно понимать его юридические и этические аспекты. Эти дискуссии служат ключевым напоминанием о том, что регулирование цифровых технологий, таких как обнаружение фальшивок, должно осуществляться ответственно, стремясь к балансу между правами и потенциальными злоупотреблениями.

За пределами видео: Будущее фальшивок

Стремительный путь технологического прогресса постоянно открывает новые горизонты. Глубоко погрузившись в эту сферу, давайте рассмотрим, как технология deepfake выходит за рамки простых трюков с изображениями или имитацией голосов и делает оговорку о потенциальном злоупотреблении в таких областях, как фабрикация целых документов.

Больше, чем кажется на первый взгляд: Разнообразные области применения глубоких подделок

Как только мы выходим из привычных рамок видео deepfake, эти инновации, конечно же, не ограничиваются обманчивыми изменениями мультимедийного контента. Очевидно, что, если экстраполировать понятие deepfake с манипуляций с видео на другие цифровые сферы, оно приобретает широкие масштабы.

Одним из основных применений, переходящих от визуального к аудио, является клонирование голоса. Достижения в области искусственного интеллекта позволяют воспроизводить уникальные особенности речи человека - тон, высоту тона, акцент, - тем самым обеспечивая реалистичность разговора, который кажется практически неразличимым. Потенциально это может стать основой для убедительных мошенничеств, основанных на поддельных телефонных звонках, или стимулирования вредоносной деятельности с помощью персонализированных попыток фишинга.

Еще один скачок вперед - генерирование поддельного текстового контента или создание фальшивых документов. Сложные модели машинного обучения могут быть обучены с использованием обучающих данных о стилях письма, индивидуальных предпочтениях в выборе слов, использовании фраз в течение определенного времени, в результате чего создаются сфабрикованные тексты, имеющие полное сходство с подлинными. Искажение становится особенно сложным, если в процессе его создания используются субъективные предубеждения; ложные истории могут тонко подтверждать уже существующие убеждения людей и дискредитировать другие без предоставления подлинных доказательств.

Потенциальные риски и дальнейшие перспективы

Хотя изучение этих расширенных возможностей дает такие преимущества, как адаптированные инструменты обучения или погружение в игровой процесс благодаря тому, что персонажи звучат более человекоподобно, вопросы об уязвимостях безопасности вызывают беспокойство.

Возникают вопросы ответственности, поскольку вмешательство в голосовые клоны может привести к невероятно вредным последствиям, таким как подрыв репутации и вторжение в частную жизнь, если они будут использоваться для распространения дезинформации или сеяния раздора, что может вызвать необоснованное влияние на общество.

Что касается фабрикации документов с помощью технологии deepfake, то фальшивые новостные статьи могут серьезно повлиять на общественное мнение и принятие решений. Поддельный текстовый контент может оказаться более действенным, чем поддельные видео- или аудиоклипы, поскольку письменные повествования обладают большей достоверностью, чем медиаконтент.

По мере того как мы распутываем эти вероятные сценарии будущего о том, что такое deepfake, возникает необходимость не только в прогрессе, но и в бдительности. Очень важно уравновешивать технологические достижения надежными мерами безопасности, пропагандировать прозрачное использование и расширять правовые границы, сохраняя в центре внимания интересы человека.

Образовательные и просветительские кампании

В нашем технологически развитом обществе одним из ключевых аспектов решения проблемы глубоких подделок является просвещение и информированность. Понимание того, что такое глубокая подделка, а также ее потенциальных последствий, имеет решающее значение.

Важность просвещения общественности о существовании и последствиях глубоких подделок

Как мне кажется, понимание и осведомленность общественности о глубоких подделках может стать эффективной первой линией обороны против их использования в неблаговидных целях. Повышение осведомленности об этих искусно синтезированных продуктах может противостоять их потенциальному распространению, влиянию и вытекающим из этого последствиям.

Позвольте мне объяснить, почему образование в этом вопросе жизненно важно:

- Поощряет разборчивость: Более глубокие знания побуждают к критическому анализу, прежде чем делиться или действовать на основе информации, полученной из СМИ.

- Внушает осторожность: Осознание обманчивых методов манипулирования способствует необходимому скептицизму при потреблении цифрового контента.

- Поощряет ответственность: Вооружившись информацией об идентификационных признаках глубоких подделок, пользователи с большей вероятностью сообщат о подозрительных действиях.

Все эти элементы в совокупности создают мощные инструменты самоцензуры, которые должны быть у каждого пользователя Интернета. Однако обучение таким важным навыкам требует хорошо продуманных образовательных маршрутов.

Инициативы и программы, направленные на повышение осведомленности и развитие навыков медиаграмотности

Медиаграмотность - способность определять различные типы технологий производства медиа - для всех поколений становится насущной необходимостью, особенно в условиях появления манипулятивных технологий, таких как deepfakes.

Было запущено множество инициатив, направленных на решение этой конкретной задачи. Позвольте мне остановиться на некоторых из них:

- В партнерстве с Jigsaw (подразделение Alphabet) газета The New York Times выпустила проект "Операция "Инфекция"", направленный на просвещение людей об истории и широком влиянии кампаний по распространению ложной информации.

- MediaWise для пожилых людей: Проект Института Пойнтера, ориентированный на взрослых пользователей MTurk старше 50 лет - группу, которая чаще всего становится жертвой обманчивого копирования новостей, - и обучающий их тому, как отличить подлинный цифровой контент от мошеннического.

- Компания Sensity AI (бывшая DeepTrace Labs) посвящает свою деятельность разоблачению глубоких подделок, регулярно публикуя информацию о развитии технологии и проводя информационные кампании.

Принятие таких обнадеживающих инициатив - привитие важнейших знаний, позволяющих ориентироваться в интернете разборчиво и безопасно, - является основой для принятия действенных мер в ответ на вызов, брошенный глубокими подделками. В конце концов, с большой силой приходит и большая ответственность!

Краткое изложение ключевых моментов, рассмотренных в конспекте

Для начала, чтобы понять термин "глубокая подделка", мы изучили его определение и корни. Затем мы рассмотрели несколько известных случаев, когда глубокие подделки попадали в заголовки газет. Исследуя, что такое deepfake, мы размышляли об эволюционном пути - от инновационной концепции до продвинутого использования.

Затем мы подробно описали процесс создания фальшивки, что было необходимо для понимания технологии, лежащей в ее основе: искусственного интеллекта и машинного обучения. Несомненно, создание реалистичных глубоких подделок сопряжено с определенными трудностями, что указывает на интригующие ограничения в этой передовой технологической сфере.

Мы также сосредоточились на анализе обеих сторон их влияния - негативных аспектов, таких как дезинформация и нарушение конфиденциальности, и позитивных, таких как развлечения или вогуанские формы искусства. Всегда помните, что у каждой монеты есть две стороны; это особенно верно при изучении того, что такое deepfake.

На следующем этапе мы рассмотрели методы и усовершенствования, применяемые для обнаружения этих гиперреалистичных творений. Поверьте, расшифровать реальный и обманный контент не так-то просто! Но не стоит расстраиваться: каждый может сыграть свою роль в борьбе с вредоносными подделками - отдельные люди, технологические компании и гиганты, даже правительства.

Дебаты вокруг законов, касающихся глубоких подделок, показали нам, как различаются правовые взгляды в разных странах, и раскрыли множество этических аспектов, над которыми стоит задуматься при регулировании и цензуре, связанных с этой технологией.

Использование deepfake выходит за рамки видео; манипуляции с голосом или поддельные документы демонстрируют потенциальные риски, связанные с расширением применения этой технологии. Постоянная бдительность - вот мантра цифровой эпохи!

На заключительном этапе обсуждения темы "Что такое Deepfake?" особое внимание было уделено образовательным кампаниям - важнейшим инициативам, рассказывающим людям о возможных последствиях и способствующим развитию навыков медиаграмотности среди нетизенов по всему миру.

Заключительные мысли о будущих последствиях и влиянии технологии Deepfake

Завершая наше путешествие к пониманию того, что такое deepfake, я с удивлением и в то же время с осторожностью думаю о его будущих последствиях. Появление технологии deepfake открывает беспрецедентные возможности для инноваций в различных областях, таких как кинематограф, игры или виртуальная реальность. Но она не лишена и потенциальных подводных камней: ее неправильное использование может нанести вред личной жизни и обществу.

Тем не менее, люди разработали эту технологию, поэтому от нас зависит, насколько ответственно мы будем ее использовать и как умело управлять ее результатами. Постоянное развитие технологий обнаружения и эффективное регулирование будут играть важную роль в сдерживании нежелательных последствий и обеспечении процветания законного использования.

По мере того как мы перемещаемся по этому постоянно развивающемуся цифровому морскому пейзажу, изучение таких сложных технологий, как deepfakes, оттачивание навыков медиаграмотности и бдительность в отношении возможных злоупотреблений становятся как никогда важными. Продолжайте исследовать с информированным умом и проницательным взглядом - вот мой последний совет вам!

В конечном счете, феномен фейков учит нас одной важной истине: с огромной технологической мощью приходит и большая ответственность!

15 000 настраиваемых активов 3D-дизайна

для дизайна UI/UX, веб-сайтов, приложений и многого другого. Зарегистрироваться бесплатно